025美国AI监管政策变迁:解读美国联邦政府《确保人工智能国家政策框架》行政令 ——兼论“法律碎片化”背景下中国AI企业出海的合规启示

2025美国AI监管政策变迁:解读美国联邦政府《确保人工智能国家政策框架》行政令

——兼论“法律碎片化”背景下中国AI企业出海的合规启示

当地时间2025年12月11日,美国总统唐纳德·特朗普签署了《确保人工智能国家政策框架》(Ensuring a National Policy Framework for Artificial Intelligence)行政命令(下称“《确保行政令》”)。

这一举措标志着美国政府正式向各州碎片化的AI监管提出挑战,意图通过联邦层面的“抢占立法权”(Federal Preemption),建立一个统一、弱监管、去意识形态化的全国性AI监管法律体系。其根本战略意图在于通过消除国内(联邦与州、州与州之间的)法律壁垒,整合国家基础设施、算力与创新资源,以举国体制的姿态与中国在人工智能领域展开竞争。

【内容介绍】本文分为上下两部,旨在全景式解析2025年美国联邦和州两级政府在AI监管政策的变化,在此基础上对中国AI企业出海美国的合规体系搭建提出建议。

上篇(第一、二章)将介绍《确保行政令》主要内容,并简要勾勒出美国联邦政府在AI监管上关注的核心议题以及为消除AI监管州级碎片化、确立全球主导地位等问题上的政策。下篇(第三、四章)将在分析以加利福尼亚州、科罗拉多州为代表的美国州级AI强监管法规的基础上,对中国AI企业出海的合规体系搭建提出建议,包括放弃单一的“黄金标准”,转而利用“地理围栏”(Geo-fencing)、“低秩自适应”(LoRA)及“小模型策略”(Thin Model)搭建灵活坚韧的AI合规体系。

上篇(第一、二章)

一、 《确保行政令》内容介绍

《确保行政令》指出,在AI监管问题上,当前美国各州存在碎片化及过度监管的问题。要赢得竞争,美国的人工智能企业必须能够在不受繁琐监管束缚的情况下自由创新(To win, United States AI companies must be free to innovate without cumbersome regulation)。

《确保行政令》

《确保行政令》认为,首先,各州各自为政的监管方式本质上会造成50套互不相同的监管体系,形成支离破碎的法规格局,使合规变得更加困难,尤其对初创企业而言更是如此。其次,越来越多的州法律迫使开发者在人工智能模型中嵌入意识形态偏见。例如,科罗拉多州一项新近出台的禁止“算法歧视”的法律,可能迫使AI模型为了规避对受保护群体造成“差别待遇或影响”而生成不真实的结果。再次,某些州法律有时会越权规制州外事务,不当干预州际商业活动(Interstate Commerce),意指州立法权侵犯了联邦政府对州际贸易的管辖权。

针对上述问题,特朗普政府提出,必须与国会携手行动,确保建立一套负担最小化的全国统一标准,而非50套彼此冲突的州级法规。由此形成的框架必须禁止与《确保行政令》所确立政策相冲突的州法律。同时,该框架还应确保保护儿童、防止审查、尊重版权以及保障社区安全。一套精心设计的全国性框架将确保美国赢得人工智能竞赛。

为了达到上述目的,《确保行政令》确立了一系列行动方案,包括(3~7条):

l第3条Sec. 3. AI诉讼行动组(AI Litigation Task Force),本命令发布之日起30日内,司法部长设立一个AI诉讼行动组,其唯一职责是挑战与第2条所列政策不一致的州级人工智能法律(第2条,通过一套负担最小化的国家人工智能政策框架,维持并加强美国在全球人工智能领域的主导地位)。

l第4条Sec. 4. 州人工智能法律评估(Evaluation of State AI Laws),本命令发布之日起90日内,商务部长发布一份对现有州人工智能法律的评估报告。该评估至少须明确识别以下类型的法律:(1)要求人工智能模型篡改其真实输出结果的法律;(2)可能强迫人工智能开发者或部署者以违反《宪法第一修正案》或其他宪法条款的方式披露或报告信息的法律。

l第5条Sec. 5. 州拨款限制(Restrictions on State Funding),本命令发布之日起90日内,商务部长应发布一项政策通知,明确各州在何种条件下有资格获得通过本政府“物有所值”(Benefit of the Bargain)改革所节省下来的“宽带公平接入与部署”(BEAD)计划剩余资金。凡被第4条识别为具有繁苛人工智能法律的州,在联邦法律允许的最大范围内,不得获得非部署类资金。州政府也不得颁布与本命令政策相冲突的人工智能法律(否则将面临联邦政府拨款缩减)。

l第6条Sec. 6. 联邦报告与披露标准(Federal Reporting and Disclosure Standard),在第4条所要求的法律评估结果公布后90日内,联邦通信委员会(FCC)主席应启动程序确定是否采用联邦层面的人工智能模型报告与披露标准,并以此排除州法律的适用(preempted)。

l第7条Sec. 7. 优先适用联邦法律以禁止州法强制人工智能模型实施欺骗行为(Preemption of State Laws Mandating Deceptive Conduct in AI Models),本命令发布之日起90日内,联邦贸易委员会(FTC)主席应发布一项政策声明,阐明《联邦贸易委员会法》(《美国法典》第15编第45条)关于禁止“不公平或欺骗性行为或做法”的规定如何适用于人工智能模型。该政策声明必须明确指出:当州法律要求人工智能模型修改其真实输出时,此类法律因与《联邦贸易委员会法》禁止影响商业的欺骗性行为的规定相冲突,而被联邦法律排除(preempted)。

二、 美国联邦政府AI监管政策变迁

2.1 特朗普政府的AI监管政策

在美国,行政令(Executive Order)是美国总统发布的、用于管理联邦政府运作的指令。行政令仅对联邦政府的行政部门具有约束力。其法律或宪法依据通常被认为来源于《美国宪法》第二条赋予总统广泛的行政与执法权,使其可自行裁量如何执行法律,或以其他方式管理联邦行政部门的资源与人员。由于行政令并不是法律,除联邦政府的行政部门之外,其他部门可以不服从于行政令,但是近年来随着美国行政权力的扩张,行令已有替代(甚至部分废除)立法的效果。

特朗普自2025年上任以来已签署多个涉及人工智能监管的行政令,包括:

l2025年1月23日签署的《消除美国在人工智能领域领导地位的障碍》(Removing Barriers to American Leadership in Artificial Intelligence)行政令,该行政令距离拜登政府在离任前签署的最后一份关于人工智能的行政令不足十日,明确撤销拜登政府第14110号行政令(下文将涉及的《提升美国在人工智能基础设施领域领导地位》),将国家政策重心从“防范AI风险”转移到“维持和增强美国在全球AI领域的绝对统治地位”。

l2025年7月23日签署的《阻止“觉醒”式人工智能》(Preventing Woke AI in the Federal Government)行政令,该行政令要求联邦政府阻止“觉醒”式人工智能(受到多样性、公平和包容DEI原则训练,而拒绝回答事实性问题、歪曲历史事实或审查受宪法保护的言论的AI系统),规定联邦机构应当仅采购“不带偏见”、“意识形态中立”的大型语言模型;

l2025年10月1日签署的《利用人工智能攻克儿童癌症》(Unlocking Cures for Pediatric Cancer with Artificial Intelligence)行政令,该行政令聚焦AI技术在儿童癌症领域的应用,要求美国卫生与公共服务部加大资金支持,推动人工智能用于儿童癌症的诊断、治疗和预防研究;

l2025年11月24日签署的《启动人工智能“创世纪计划”》(Launching the Genesis Mission)行政令,该行政令指令能源部创建人工智能实验平台,整合美国超级计算机、国家实验室的海量科学数据和自动化实验设施,构建国家级科研平台,利用AI变革科学研究方式,加速新药研发、核聚变能源等关键领域的突破。

2.2 拜登政府的AI监管政策

相对于特朗普在美国优先(American First)的宗旨下积极甚至略带激进式的AI监管政策,拜登政府时期签署的涉及AI的行政令及发布的政策则更偏向于安全、可信与保守。其逻辑在于通过监管来建立信任,只有确保AI是安全、无歧视且绿色的,公众才会接受AI。

l2023年10月30日签署的第14110号行政令《安全、可靠和值得信赖的人工智能》(Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence),系拜登政府首份针对人工智能安全发展的监管性行政令,强制要求科技巨头向政府报告由于AI开发带来的潜在国家安全风险,其主要内容包括:确保人工智能技术的安全与保障,促进创新与竞争,支持劳动者,推进公平与民权,保护消费者、患者、乘客和学生,保护隐私,推动联邦政府对人工智能的应用,加强美国在海外的领导力,设立白宫人工智能委员会协调联邦政府各机构的活动以及AI相关政策的实施等。

l2025年1月14日,拜登总统任期的最后一周,签署了《提升美国在人工智能基础设施领域领导地位》(Advancing United States Leadership in Artificial Intelligence Infrastructure)行政令,该行政令聚焦AI基础设施建设,旨在通过完善算力和能源配套巩固美国AI全球领先地位。其要求联邦机构为AI数据中心、清洁电力设施提供场地,加快电网互联和许可审批;国防部、能源部通过竞争性租赁确定私营部门开发AI基础设施的地点,且AI开发商需承担联邦土地上基础设施的建设、运营和维护费用;同时强调供应链安全,保障AI基础设施关键组件的稳定供应。该行政令关注AI基础设施建设,其政策在特朗普时期也得到延续。

下篇(第三、四章)

三、 各州强监管AI监管法规

由于两党在AI监管方式、力度及优先事项(如创新、安全)上的深刻分歧,始终未能通过一部类似欧盟《人工智能法案》(EU AI Act)的联邦法律,各州法律出现不一致的监管思路则不足为奇。

根据美国全国州立法机构联合会(National Conference of State Legislatures)的统计数据,今年全美所有50个州都提出了涉及AI的法案(但大多法案是诸如教育、劳动、健康等特定领域的而非综合性AI监管法案),已有38个州已通过了或实施了约100项法案(截止7月)。这其中具有代表性的,也是在《确保行政令》中被“点名”的加利福尼亚州和科罗拉多州的监管立法,则显示出州立法机构在AI监管上严重分歧。

3.1 加利福尼亚州 - “萨克拉门托效应”(Sacramento Effect)

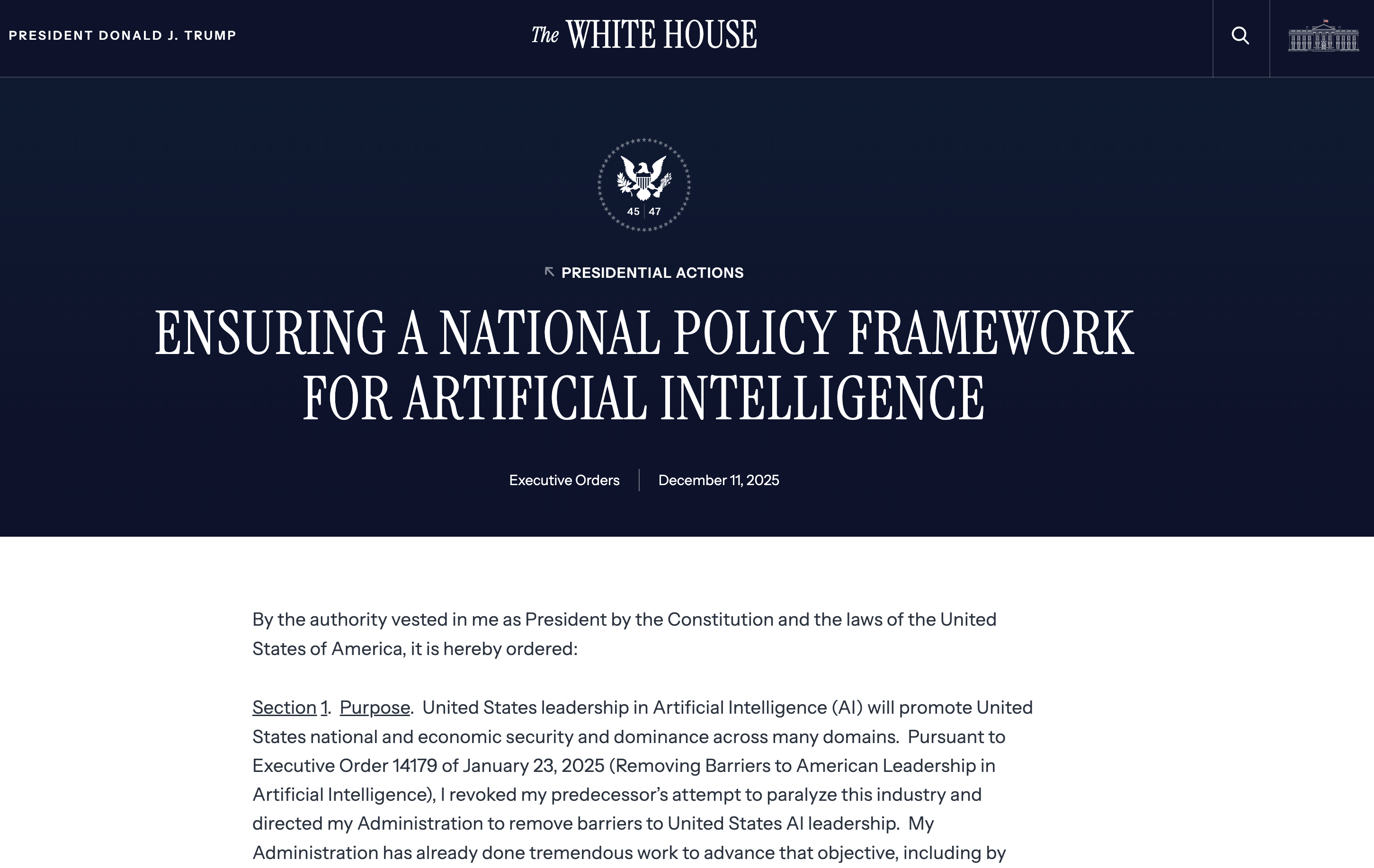

加州最具代表性的法案为SB 1047《前沿人工智能模型安全创新法案》(Safe and Secure Innovation for Frontier Artificial Intelligence Models Act)。该法案由加州民主党参议员Scott Wiener于2024年2月7日提出,旨在为大型AI模型设立“安全护栏”,但在2024年9月29日被加州州长加文·纽森(Gavin Newsom)否决。

SB 1047的合规义务并不适用于所有AI,其引入了“算力+成本”双重标准来定义监管对象--适用于那些训练成本超过1亿美元、且所使用的计算量超过1026次浮点运算的模型。使用计算量作为门槛借鉴于《欧盟人工智能法》(EU AI Act)。因此计算量大的通用大模型,包括OpenAI,Google Gemini,Anthropic Claude等头部大模型,都将受到SB 1047监管,但避开了绝大多数初创公司的小模型。该法案本将为举报人/吹哨人(whistleblower)提供保护,并要求开发者在发布其模型前进行风险评估,并接受政府运营局(Government Operations Agency)的指导。

SB 1047率先提出模型开发者应当具备对大模型的一键关闭的能力(Implement the capability to promptly enact a full shutdown)、在模型开始训练之前(而非发布后),开发者必须提交详细的《安全与安保协议》(Safety and Security Protocol)、建立一个由公共财政资助的云算力集群(public cloud computing cluster to be known as “CalCompute”)。这样的强监管法案自然遭到OpenAI、Google、Meta等科技巨头的反抗。

加州州长加文·纽森在否决SB 1047的声明中首先肯定了提案的本意(thoughtful proposals & well-intentioned),也十分认同Safety protocols条款的必要性(Let me be clear - I agree with the author)。纽森解释到否决的主要原因在于其认为标准不够科学,即仅以“成本”或“算力大小”来判断AI风险是不明智的(Key to the debate is whether the threshold for regulation should be based on the cost and number of computations needed to develop an Al model),因为小模型在特定场景下(如生物实验室)可能比通用大模型更危险。同时,纽森指出了制定AI监管法案的紧迫性和必要性,尤其是在缺乏联邦级别统一立法的情况下(A California-only approach may well be warranted - especially absent federal action by Congress - but it must be based on empirical evidence and science),事实上暗示联邦政府应当尽快制定全国性的法案(I am committed to working with the Legislature, federal partners, technology experts, ethicists, and academia, to find the appropriate path forward)。

截止2025年12月,加州已经有数十项已经签署的涉及人工智能监管的法案,比较重要的包括:

l2024年9月28日签署的AB-2013 Generative artificial intelligence: training data transparency《生成式人工智能:训练数据透明度》,这是一项仅三页的法案,要求开发者必须在其官方网站上公开一份清晰、可访问的文档,内容包括:数据集的高级摘要(high-level summary of datasets),描述用于训练模型的主要数据来源类型;说明是否包含受版权、商标或专利保护的数据,是否包含“个人信息”或“消费者汇总信息”,是否完全属于公有领域;数据集是否由开发者购买或获得许可;开发者是否对数据集进行了清洗、处理或其他修改,并说明此类操作相对于该人工智能系统或服务的预期目的;在开发过程中是否使用或持续使用合成数据生成技术等。

l2025年9月29日签署的SB 53, Wiener. Artificial intelligence models: large developers《人工智能模型:大型开发者》,该法案实际上是SB 1047被否决后的替代性法案,在纽森否决SB 1047当日签署。法案要求年营收超5亿美元的开发者必须每年公布详细的“安全与安保框架”,说明如何管理灾难性风险,并包括了公共算力集群计划(CalCompute)的相关内容。

l2025年10月10日签署的SB 524, Arreguín. Law enforcement agencies: artificial intelligence《执法机构:人工智能》,该法案要求凡由执法人员或执法机构成员使用人工智能生成全部或部分的正式报告中,必须在每一页显著位置标注“AI生成”声明,必须永久保留AI生成的原始草稿以供审计,执法人员必须签字确认报告准确性,承担最终法律责任,以及禁止AI供应商利用执法数据训练通用模型或转售。

l2025年10月13日签署的SB 243, Padilla. Companion chatbots《陪伴型聊天机器人》,法案要求陪伴型聊天机器人平台的运营商发布清晰且显著的通知,表明该聊天机器人是由人工智能生成而非真人,以及运营商应当制定协议以防止向用户提供关于自杀念头、自杀行为或自残的内容,并需在其网站上公布该协议的具体细节。

l2025年10月13日签署的AB 316, Krell. Artificial intelligence: defenses《人工智能:抗辩事由》,该法案禁止被告(开发、修改或使用人工智能的人)提出一种辩护理由,即声称人工智能自主地造成了对原告的伤害。即如果某个人工智能系统造成了损害,该系统的开发者、修改者或使用者不能以“人工智能自主决策导致了损害”作为免责的辩护理由。

硅谷作为全球AI中心,由于AI技术的通用性及不可分割性,为了避免维护多套合规体系的高昂成本,企业往往被迫以加州最严法规为基准。因此,加州制定的法律标准往往会自动“溢出”,成为全美乃至全球通行的“事实标准”(De Facto Standard)。

3.2 科罗拉多州 -《人工智能消费者保护法》

科罗拉多州最具代表性的法案为SB 24-205 Consumer Protections for Artificial Intelligence《人工智能消费者保护法》。

该法案要求,自2026年2月1日起,高风险人工智能系统的开发者采取合理注意义务(reasonable care),以保护消费者免受该高风险系统中已知或可合理预见的算法歧视风险,法案要求开发者:

1) 向部署者提供法定信息披露声明;

2) 提供支持其开展算法影响评估所需的完整技术文档;

3) 公开披露所涉高风险系统类型及其算法歧视风险管理措施;

4) 在发现或收到可信报告后90日内,及时向州总检察长及相关方通报已知或可预见的算法歧视风险。

SB 24-205深受《欧盟人工智能法》(EU AI Act)的影响,可视为《欧盟人工智能法》对高风险人工智能系统监管的一个缩影,也展示出了布鲁塞尔效应(Brussels Effect)在数字法监管上的深远影响。

3.3 弱监管州立法

在加州和科罗拉多州为代表的强监管之外,美国其他州的立法则较为宽松,例如犹他州SB 149《人工智能政策法案》(AI Policy Act)规定如果如实披露AI的使用,则不构成欺诈,与加州《人工智能:抗辩事由》禁止被告以AI自主决策作为抗辩形成鲜明的反差。

共和党控制的佛罗里达州制定的SB 262《数字权利法案》(Digital Bill of Rights)则直接豁免全球年总收入不超过10亿美元的企业(In excess of $1 billion in global gross annual revenues),其受监管的主体定义为控制者(Controller),由于合规义务还要求满足以下要求,其监管显然剑指位于加州的Google、Apple、Meta、Amazon等科技巨头:

l50%收入来自广告-针对Google和Meta(Derives 50 percent or more of its global gross annual revenues from the sale of advertisements online);

l运营智能音箱或语音助手-针对Amazon和Apple(Operates a consumer smart speaker and voice command component service with an integrated virtual assistant connected to a cloud computing service);

l运营拥有超过25万个应用的应用商店-针对Apple和Google(Operates an app store or a digital distribution platform that offers at least 250,000 different software applications for consumers to download and install)。

四、 《确保行政令》对中国AI企业出海的启示

在以往协助中国企业出海时,利用“布鲁塞尔效应”(Brussels Effect),企业通常会将欧盟《通用数据保护条例》(GDPR)这一全球最严苛的隐私保护法案作为蓝本,制定一套内部的“黄金标准”。这套标准能够直接适用于与GDPR保护力度相当的国家或保护力度低于欧盟的国家(如东南亚、拉美等大部分地区);而对于个别标准高于GDPR的地区,企业只需在此基础上进行本地化调整即可。

同样的逻辑也适用于美国市场。受“萨克拉门托效应”(Sacramento Effect)的影响,加利福尼亚州作为美国科技与创新的中心,其立法往往具有全美风向标的作用。出海企业以往只要满足了加州(及伊利诺伊州等州)最严格的消费者隐私法案(CCPA/CPRA),往往也就意味着满足了全美50个州的合规底线。这种“一处合规,处处通行”的策略,极大地降低了跨国企业的边际合规成本。

然而,对于出海的AI企业而言,美国各州法律的日益碎片化与互斥,使得“统一模型”策略在法律层面难以为继。一套在某州合规的算法,极可能在另一州触犯监管红线。考虑到AI模型高昂的算力成本、复杂的部署流程及持续迭代的需求,若要求企业针对全美50个州分别训练并维护50个不同版本的模型,不仅技术上难以实现,更将导致合规成本呈指数级爆炸,这在商业逻辑上显然是不可行的。

美国现任政府显然也意识到,如果一家AI企业必须为50个州开发50种不同版本的模型,合规成本将呈指数级上升,这将严重阻碍本土创新或阻止外部企业进入美国市场。相比之下,中国拥有统一的中央监管体系,合规义务清晰、一致,AI企业在全国范围内仅需适用一套标准。

值得注意的是,尽管特朗普政府目前的政策旨在建立一套统一的、较为宽松的联邦AI监管体系,但出海企业仍需保持高度的战略定力与警惕,这是因为美国政治体制决定了联邦与州权的长期博弈,且执政党更迭带来的政策的更迭现象日益频繁。因此,我们建议企业不要对美国AI监管“终将统一”抱有幻想,而应当搭建一套灵活可变的合规架构,以便随时根据当地法规的变化进行调整。

4.1 地理围栏 (Geo-fencing)

由于“真实输出”标准的不确定性,中国企业出海后将面临不同法域对输出内容的差异化要求。若企业仅在中国境内使用符合中国AI监管规范的数据训练模型,往往难以直接满足海外市场的多样化合规要求,难以与当地的法规、文化或意识形态对齐(Alignment)。

为解决此类冲突,最佳实践是参考导航软件的“地理围栏”(Geo-fencing)技术,即通过IP地址或其他个人信息识别用户位置,提供符合当地法规的差异化服务。例如,由于各国(尤其是存在领土争议的邻国)对边界线划分不同,导航软件需要根据用户所在辖区展示不同的地图版本(如下图所示TomTom说明书中切换地图功能的说明)。

尽管地理围栏策略看上去最稳妥、法律风险能降到最低,但这无疑也是合规成本最高的方案。进一步地,为了100%适配当地法律,企业还可能面临模型训练、部署以及本地化进程中严重的“碎片化”。地理围栏应当作为最底层的防御手段,用于处理那些绝对不可调和的法律硬冲突。

4.2 低秩自适应策略(Low-Rank Adaptation,LoRA)

比地理围栏更为折衷的一种方案即低秩自适应(LoRA)技术,在这种架构下,企业无需为每一个法域重新训练整个大模型(Base Model)。相反,企业可以保持基座模型(Base Model)的参数冻结不变,将其作为通用的“逻辑引擎”,针对不同的州或国家的法律法规(如加州的隐私法),训练各具特色的小型“适配器”(Adapters)或“插件”。LoRA适配器的参数量通常仅为大模型的千分之一甚至更低,训练和存储成本极低。当某地法律发生变更时,企业无需回炉重造整个模型,只需重新训练那个微小的Adapter即可。这种方法不仅能大幅降低计算资源的需求,还能有效减少合规成本,同时保证了模型的灵活性和适应性。

4.3 小模型策略 (Thin Model)

受欧盟《人工智能法案》的影响,将“计算量”作为监管门槛正逐渐成为一种全球立法趋势。因此,对于属于非通用人工智能公司(Non-AGI)的AI公司,可考虑在目的国部署计算量小于1026FLOPs浮点运算的模型,从而进入非监管或豁免的范围。

在此背景下,对于专注于特定垂直领域(如医疗影像分析、法律文书生成、工业质检等)的非通用人工智能公司,可策略性地设计和部署其模型,使其训练或推理阶段的计算量严格控制在1026FLOPs浮点运算以下。通过在目标市场本地化部署此类轻量化、低算力模型,企业有可能被排除在“高风险AI系统”或“前沿基础模型”的监管范畴之外,从而享受豁免或简化合规义务。这种“算力合规”路径尤其适用于资源有限但技术聚焦的垂类AI企业,既能满足本地市场需求,又能有效规避繁重的监管成本。

最后,出海企业在与当地合作伙伴签订合同时,应特别注意加入情势变更条款。这些条款应在合同中明确规定,如果因为法规和政策的变化导致合同不能履行,属于免责事由。

免责申明:本报告系基于公开资料及政策文件所撰写的法律研究报告,不构成任何形式的法律意见或专业建议。如您对本报告内容有任何疑问或需要进一步澄清,请与本所或作者取得联络。